Visuelles ASsistenzsystem zur Computergestützten Orientierungs- und Handlungsfähigkeit

Name: KI-basiertes Visuelles ASsistenzsystem zur Computergestützten Orientierungs- und Handlungsfähigkeit für Menschen mit Seheinschränkungen/ VASCO

Zeitraum: 1. Januar 2023 bis 31.12.2025

Inhalt: Entwicklung eines KI-basierten, tragbaren Assistenzsystems zur Unterstützung von Menschen mit Seheinschränkungen

Förderung: Photonik für die digital vernetzte Welt – schnelle optische Kontrolle dynamischer Vorgänge/ BMBF

Hintergrund

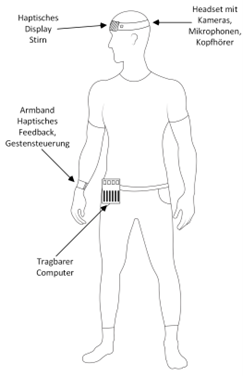

Eine unstrukturierte und dynamische Umgebung stellt für Menschen mit Seheinschränkungen eine große Herausforderung dar. Obwohl zur Orientierung und Mobilität grundlegende Techniken erlernt werden, ergeben sich im Alltag vielerlei Szenarien, bei denen man auf eine externe Unterstützung angewiesen ist. An dieser Stelle knüpft das Forschungsvorhaben an und bezweckt die Entwicklung eines tragbaren Assistenzsystems bestehend aus Eingabegeräten (Kameras, Mikrofon), einer Recheneinheit und Ausgabegeräten (Kopfhörer und taktile Geräte).

Unterstützt durch künstliche Intelligenz (KI) und schnelle Datenverarbeitung optischer Sensoren soll der Anwender über die Ausgabegeräte in Echtzeit mit situationsbedingten dynamischen Informationen versorgt werden, die ihm dabei assistieren, gezielte Aktionen zur Orientierung, Bewegung und Handlung auszuführen. Hierzu gehören die selbstständige Orientierung und Fortbewegung im öffentlichen und geschlossenen Raum sowie die Bewältigung von Tätigkeiten im Haushalt. Dadurch hat das visuelle Assistenzsystem keine rein passive oder warnende Funktion, sondern ist vielmehr aktiv in die Aktionen und das Verhalten des Benutzers eingebunden.

Projektziel

Im vorliegenden Projekt soll ein tragbares Assistenzsystem zur Unterstützung von Menschen mit Seheinschränkungen entwickelt werden. Das Assistenzsystem soll – wie der nebenstehenden Abbildung zu entnehmen ist – getragen werden und den Anwender bei vielfältigen und für das tägliche Leben relevanten Situationen unterstützen. In einem Headset ist ein 3D-Kamerasystem zur Erfassung des Umfeldes integriert. Rückmeldungen an den Anwender des Assistenz-systems sollen insbesondere über ein taktiles Display sowie akustisch über einen Kopfhörer erfolgen. Das taktile Display soll in das Headset integriert werden und an den Anwender über die Stirn in Echtzeit situationsbedingte und gut differenzierbare Informationen übermitteln. Die Datenverarbeitung und Stromversorgung erfolgt über einen kompakten, tragbaren Rechner. Die im Headset integrierten Kameras erfassen direkt die Umgebung des Anwenders visuell und erzeugen über KI ein situationsabhängiges Umfeldmodell. Selektive Informationen sollen auf dieser Basis mit hoher Genauigkeit und Differenzierbarkeit aufbereitet und als Teil einer Regelung sowohl akustisch als auch taktil an den Anwender übermittelt werden. Darüber hinaus soll ein Armband mit taktilem Feedback Greifbewegungen unterstützen, indem während der Bewegung unmittelbare spürbare Hinweise zur Korrektur der Bewegungsrichtung gegeben werden. Der Mensch reagiert schließlich entsprechend dem erhaltenen Feedback und schließt durch die Ausführung seiner Aktionen die Rückkopplungsschleife. Für eine bessere Koordination seiner Aktionen und Bewegungen mit der dynamischen Umgebung (z.B. Greifen und Handhaben von Objekten, Kollisionsvermeidung usw.) ist eine robuste Erfassung der Umgebung sowie eine schnelle Datenverarbeitung und Informationsbereitstellung von zentraler Bedeutung.

Um das System zu steuern und zu konfigurieren, kann der Anwender Sprachbefehle oder Gesten einsetzen. Die KI des Systems soll allerdings auch selbständig die Situation und die Intention des Anwenders erkennen (sog. “Scene Understanding”). Damit werden autark, d.h. ohne aufwendige Konfiguration seitens des Anwenders situationsbedingte Unterstützungen (“Entscheidungsfindung” und “Pfadführung”) ermöglicht.

Um die Informationen für den Benutzer in Echtzeit bereitstellen zu können ist die Entwicklung von schnellen und energieeffizienten Algorithmen notwendig, die eine automatisierte und selbstlernende Erfassung, Verarbeitung und Interpretation der dynamischen Umgebung ermöglichen, mit dem Ziel der Realisierung eines kompakten und mobilen Systems mit latenzarmer Informationsbereitstellung. Dadurch soll ein Demonstrator entstehen, der die Basis für die serienreife Entwicklung eines visuellen Assistenzsystems bildet.

Projektinhalt

Das BFW Düren ist als Projektpartner an diesem Projekt beteiligt um Erfahrungen aus dem Bereich des Mobilitätstrainings in das Projekt als Teilvorhaben einfließen zu lassen.

Um das System für die Zielgruppe funktionsfähig zu entwickeln, ist es erforderlich die Orientierung- und Bewegungsmuster der Zielgruppe, die diese zum sicheren Fortbewegen und Durchführung manueller Tätigkeiten im Haushalt erlernen, zu identifizieren. Ebenso erforderlich ist es die kritischen Situationen der Zielgruppe bei der Bewegung im öffentlichen Raum und die möglichen Bewältigungsstrategien zu kennen, damit diese durch das System identifiziert und berücksichtigt werden können. Zudem ist es für das Vertrauen und der Akzeptanz der Anwender überaus wichtig, wenn die Orientierungs- und Bewegungshinweise des verwendeten Assistenzsystems den erlernten Mustern entsprechen.

Der Zweck dieses Teilvorhabens ist es die Erkenntnisse des Mobilitätstraining für hochgradig sehbehinderte und blinde Menschen bezüglich der Fortbewegung im öffentlichen Raum, sowie manuelle Tätigkeiten im Haushalt, systematisch in das Assistenzsystem einfließen zu lassen.

Dies soll sicherstellen, dass:

- Orientierung und Fortbewegung im öffentlichen Raum sicher stattfinden kann

- Spezifizierte manuelle Tätigkeiten im Haushalt kollisions- und fehlerfrei durchgeführt werden können

- Informationen durch das Assistenzsytem qualitativ und quantitativ angemessen an den Anwender weitergegeben werden

In der Projektarbeit werden die Rahmenbedingungen für die Funktionsweise des technischen Systems beschrieben. Hierfür werden entsprechende Use-Cases entwickelt, die eine sichere Fortbewegung blinder Menschen im öffentlichen Raum, sowie kollisionsfreie Muster für eine spezifizierte manuelle Handlung im Alltag beschreiben. Hierbei werden potenzielle Hindernisse und Orientierungsflächen identifiziert, die sowohl akustisch und visuell identifiziert werden können.

Ein weiteres Spektrum des Teilvorhabens besteht in der Entwicklung eines standardisierten Testverfahrens zur Bewertung der Funktionsfähigkeit und der Usability des Systems. Das System wird mit hochgradig sehbehinderten und blinden Teilnehmern des BFW Düren getestet. Hierzu wird in diesem Teilvorhaben eine operationalisiertes Testverfahren entwickelt, dass eine standardisierte Testumgebung in einer Labor Umgebung, im öffentlichen Raum sowie in einem geschlossenen Raum beschreibt. Die Funktionsfähigkeit des Systems wird durch Beobachtung durch einen ausgebildeten Mobilitätslehrer, der die Testpersonen begleitet, mittels standarisierter Fragebogen erfasst. Hier werden zudem die Erfahrungen von Anwendern und Trainern zur Funktionsfähigkeit, Signifikanz und Selektion der Informationen, Wahrnehmbarkeit der Informationsübertragung, Usability und Anwender-Akzeptanz des Systems dokumentiert und ausgewertet. Die Klassifikation und Gewichtung erfolgen in Anlehnung an die DIN 40080.

Projektpartner

- DC Vision Systems GmbH

- Walk Engineering

- TU Kaiserslautern

- Inventivio GmbH

Kontakt: Jürgen Hüllen

Gefördert durch: